Google rectifie les biais sexistes de son outil de traduction

Le logo de Google. - Tolga Akmen / AFP

L'algorithme de traduction de Google fait désormais apparaître des propositions plus inclusives. Une mise à jour a été déployée pour y parvenir, annonce la firme américaine. Elle est effective pour les mots a priori dépourvus de genre, que Google Traduction avait tendance à interpréter sous un prisme masculin ou féminin.

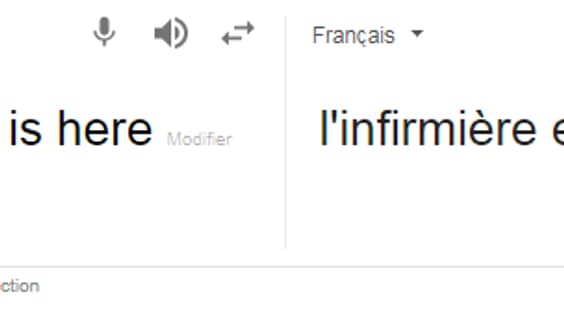

"Historiquement, Google Traduction proposait une seule traduction par requête, qu'elle puisse être au féminin ou au masculin", explique Google, en soulignant que cela avait tendance à "reproduire des biais genrés". Alors que certains mots comme "fort" ou "docteur" étaient traduits au masculin, d'autres tels qu'"infirmier" étaient assimilés à une profession féminine et traduits en tant que tels.

Un nouvel entraînement pour les algorithmes

Pour corriger ce biais, Google propose deux options de traduction, en fonction du genre à donner à la phrase. La mise à jour se restreint pour le moment aux traductions de l'anglais au français, à l’italien, au portugais et à l’espagnol, sur la version desktop de Google Traduction. Elle sera prochainement déployée pour la version mobile, sur iOS et Android.

Il y a moins d'un mois, Google avait repéré d'autres biais sexistes dans les réponses automatiques proposées par Gmail. L'entreprise avait expliqué que cela était dû au support d'entraînement des algorithmes, à savoir les mails envoyés par le plus d'un milliard d'utilisateurs de son service dans le monde.

En octobre dernier, Microsoft a également fait la part belle à une langue plus "inclusive". La dernière version du logiciel de traitement de texte Word comprenait un outil optionnel pour "éviter les formulations sexistes ou susceptibles d'exclure des minorités". La fonctionnalité déployée ciblait 'le langage genré à même d'exclure, de rejeter ou de stéréotyper", comme l'indiquait le site de l'entreprise.