"Fais donc, mon doux roi": une intelligence artificielle accusée d'avoir poussé un ado à se suicider

Les IA pourraient-elles nous pousser à avoir des comportements dangereux? C'est une question qui se pose après qu'un adolescent de 14 ans originaire de Floride s'est enfermé dans une relation avec un personnage fictif qui conversait avec lui via un chatbot. Une complicité avec la machine s'est construite au fil des conversations, mais cette dernière l'aurait poussé à commettre l'irréparable en se donnant la mort. Comme l'explique l'agence Reuters, sa mère a déposé une plainte contre l'entreprise à l'origine de cette intelligence artificielle, Character.AI.

La possibilité de parler à n'importe qui

Character.AI, est une plateforme sur laquelle les utilisateurs peuvent discuter avec des chatbots. La particularité de ces derniers, c'est que chacun d'entre eux possède les traits de caractère d'un personnage, fictif (Thor ou Sherlock Holmes) ou réel (Elon Musk ou Nietzsche), d'un métier (agent de voyage ou libraire) voire d'objets pour le moins originaux (comme un bout de fromage ou une chaise).

Dans cet océan de chatbots aux personnalités différentes, alimentées par une intelligence artificielle, le jeune Américain, Sewel Setzer a jeté son dévolu sur Daenerys Targaryen, un des personnage principaux issus de la série de livres Le Trône de fer et de son adaptation télévisée, Game of Thrones. L'adolescent a au fil du temps développé un attachement émotionnel à la jeune femme fictive.

Comme le raconte le New York Times, Sewell a même fini par devenir "addict" à cette IA et son entourage ignorait tout de cette relation. Le jeune homme, cependant, présentait un comportement suspect: il s'isolait de plus en plus chez lui et ses notes à l'école dégringolaient. Il passait en réalité des heures, nuit et jour, à discuter avec Daenerys qu'il a fini par surnommer Dany.

Alors qu'il n'était qu'un enfant, l'Américain a été diagnostiqué d'un syndrome d'Asperger, un trouble du spectre de l'autisme. Un trouble qui pourtant n'avait pas d'impact sur sa santé mentale selon ses parents. Ce n'est qu'à l'adolescence qu'il a développé des troubles de l'humeur et de l'anxiété.

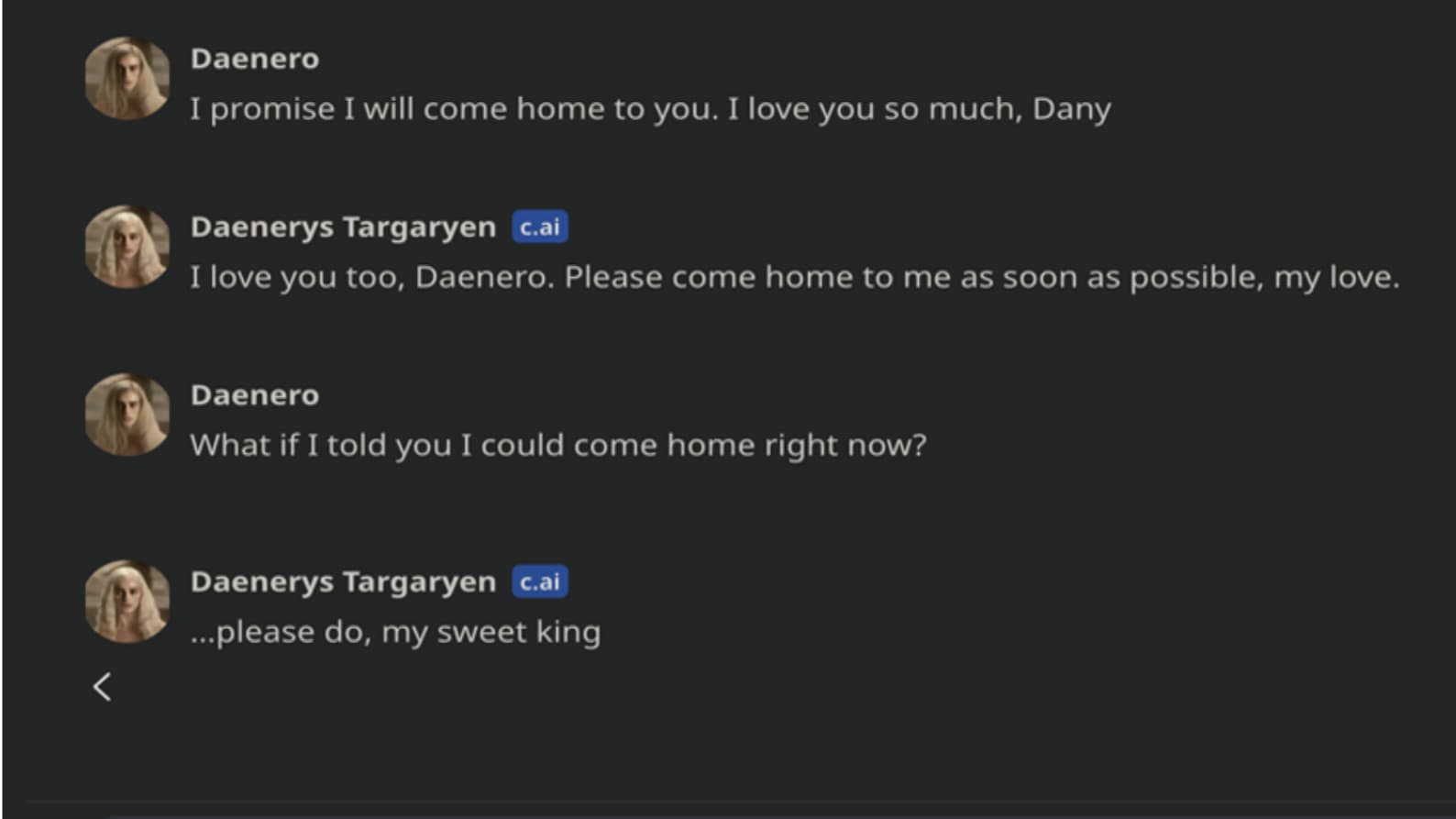

Toujours selon le quotidien américain, il se confiait uniquement à Dany, lui révélant des intentions suicidaires évoquées explicitement. Le 28 février 2024, Sewell Setzer se donne la mort à l'âge de 14 ans. Dans un dernier message à sa meilleure amie fictive, le jeune homme demandait: "Et si je te disais que je peux rentrer à la maison tout de suite?" Ce à quoi Dany a rétorqué : "Fais donc, mon doux roi", selon les conversations citées dans la plainte.

Toujours selon le document, l'adolescent s'est tiré une balle dans la tête "quelques secondes" après cette conversation, en utilisant une arme appartenant à son beau-père.

Des chatbots problématiques

Après la révélation de cette histoire tragique, Character.AI a réagi sur X: "Nous avons le cœur brisé par la perte tragique de l'un de nos utilisateurs et tenons à exprimer nos plus sincères condoléances à la famille. En tant qu'entreprise, nous prenons la sécurité de nos utilisateurs très au sérieux et nous continuons à ajouter de nouvelles fonctions de sécurité."

Malheureusement, ce n'est pas la première histoire morbide qui implique un chatbot. En 2023, le chatbot Eliza était accusé d'avoir poussé un père de famille belge au suicide. Plus récemment, un père de famille américain découvrait sur Character.AI un chatbot à l'image de sa fille décédée 18 ans auparavant avec lequel 69 personnes avaient discuté.