Qu'est-ce que Groq, l'entreprise qui espère doubler Nvidia dans la course à l'IA?

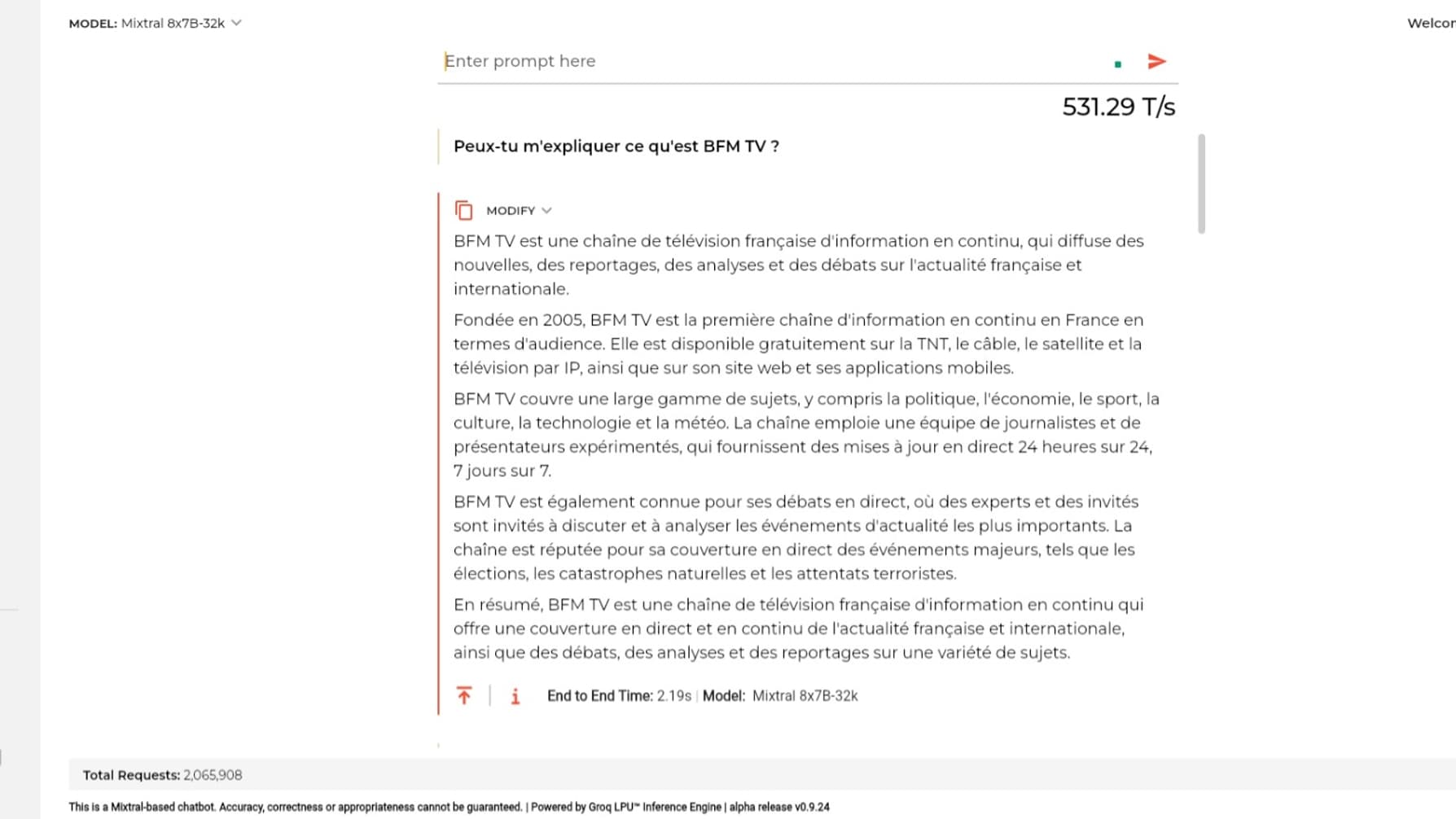

Depuis quelques mois, sur les réseaux sociaux, un fabricant de puces dédiées à l'intelligence artificielle générative fait parler de lui. Il s'agit de Groq, qui assure disposer d'une puissance de calcul bien plus importante que les puces Nvidia pour la génération de texte. Une optimisation qui permet, en pratique, de réduire ce délai, annoncé trois fois plus court que la concurrence.

Des résultats bluffants

Pour assurer cette immédiateté, Groq s'appuie sur une nouvelle architecture au niveau de ses puces, baptisée LPU, capables de faire tourner des modèles de langage déjà existants. Gravées en 14 nanomètres, une finesse qui pourrait être améliorée dans les prochaines années espère Groq, ces puces font partie intégrante de la "magie" de la plateforme, et il s'agit ici d'un véritable pari qui a été lancé en 2019.

Dans un entretien accordé au Monde Informatique en janvier 2024, le fondateur de Groq, Jonathan Ross, expliquait qu'un LPU avait certes moins de ressources qu'un processeur classique mais qu'il était au contraire bien plus puissant, ce qui réduisait considérablement la génération d'une réponse auprès de l'utilisateur. Concrètement, selon les données diffusées par Groq, une seule puce peut réaliser 1.000.000.000.000.000 (un quadrillon) d'opérations par seconde.

Ainsi, lorsque Groq génère jusqu'à 400 "tokens" (ou mots) par seconde, un processeur classique se bloque inéluctablement à 100, selon le patron de Groq. Mais le revers de la médaille, c'est que pour bénéficier de cette puissance, il faut davantage de puces Groq pour rivaliser avec les cartes de Nvidia. Le temps dira si ce nouveau concurrent arrive à être aussi polyvalent que les autres solutions, mais aussi s'il est suffisamment robuste afin de créer de nouvelles possibilités de génération.

Groq doit encore prouver sa valeur

En utilisant une architecture LPU, Groq s'évite le goulot d'étranglement d'une architecture plus traditionnelle à base de GPU (cartes graphiques) et de CPU (processeurs). Elle est conçue spécifiquement pour optimiser l'apprentissage automatique de l'intelligence artificielle.

En mars dernier, la start-up annonçait avoir réussi à adapter ses puces au chatbot de Meta qui utilise le modèle LLaMA pouvant être utilisé dans la génération de texte, alors même qu'il avait été conçu pour fonctionner sur des puces de Nvidia.

L'hégémonie de Nvidia pourrait peut-être mise à mal par les promesses de Groq, qui peut compter sur le soutien financier de plusieurs sociétés, dont Social Capital, avec lequel il a levé 52,3 millions de dollars en 2018, et qui a été fondé par un ancien de Facebook. L'entreprise dispose aussi de quelques clients encore peu connus, dont OneNano, Etanglement ou encore 1Qbit. Reste donc à Groq de prouver que sa solution peut fonctionner à une très large échelle.

Nvidia peut-il flancher face à ce concurrent qui prend de plus en plus d'importance au fil des mois? Le fabricant américain de cartes graphiques, qui a très vite pris le virage de l'intelligence artificielle, a encore de quoi faire, avec un chiffre d'affaires de près de 27 milliards de dollars en 2022, et possède 90% de part de marché sur ce secteur.

Si les puces de Groq sont impressionnantes, elles pourraient néanmoins être utilisées conjointement avec les cartes de Nvidia, créant un cercle vertueux plutôt que l'effondrement d'un acteur au profit d'un autre.