ChatGPT-4o: comment tester la nouvelle version de l'IA générative d'OpenAI?

Ce lundi 13 mai, OpenAI a dévoilé le futur de son agent conversationnel, ChatGPT, en dévoilant son nouveau modèle, GPT-4o. La conférence présentant les nouveautés était certes courte - une vingtaine de minutes - mais elle a permis de rapidement présenter les principales innovations.

L'intelligence artificielle générative d'OpenAI peut ainsi "raisonner sur l'audio, la vision et le texte", le tout, en temps réel. Les résultats présentés par la firme californienne paraissent impressionnants, suffisamment en tout cas pour rendre ce nouveau modèle disponible quelques heures à peine après sa présentation au grand public.

Traduction en temps réel, de la voix comme du texte, commentaires de flux vidéo en direct, des résultats qui s'affichent encore plus rapidement et un agent conversationnel désormais connecté en permanence à Internet... Voici quelques-unes des fonctionnalités de GPT-4o.

Comment utiliser GPT-4o dès maintenant?

Pour utiliser le nouveau modèle de langage GPT-4o, il vous faut d'abord un compte que l'on peut créer sur le site de ChatGPT.

Sur mobile:

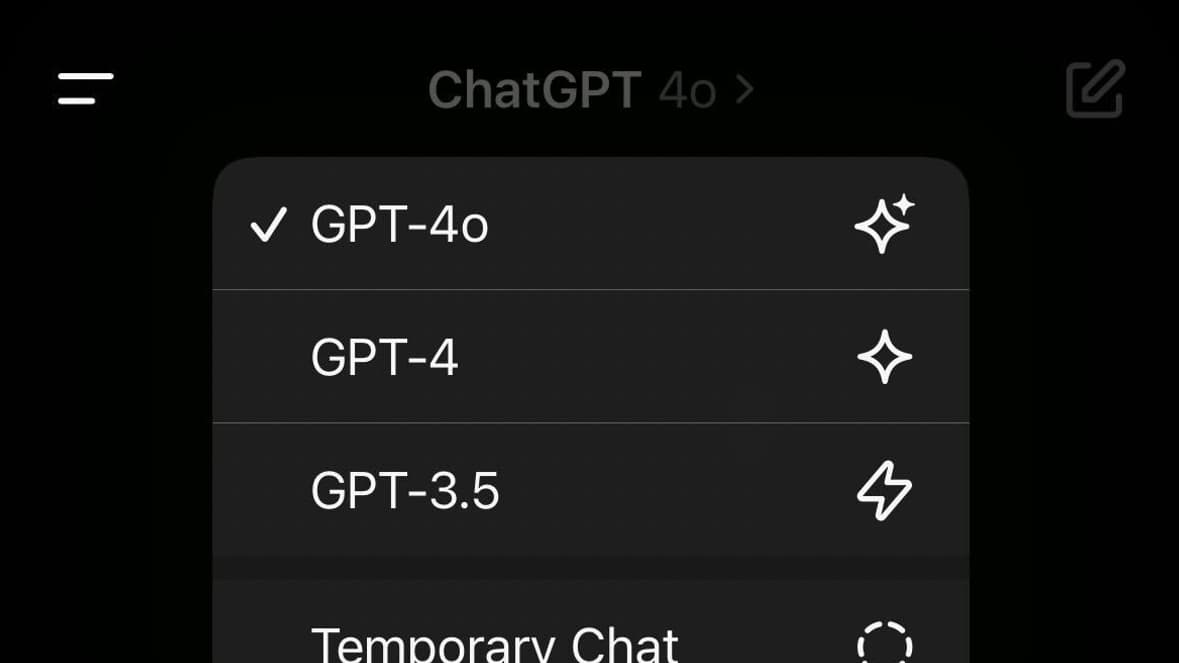

Lorsque vous lancez l'application dédiée, il faut appuyer sur le "ChatGPT>" présent en haut de l'écran. Vous serez alors en mesure de sélectionner les différents modèles proposés par OpenAI.

Sur ordinateur ou depuis le web:

Sélectionnez le modèle de langage depuis la fenêtre principale, de base, GPT-4 est sélectionné par défaut.

Vous ne voyez pas ChatGPT-4o? C'est sans doute parce que vous n'êtes pas abonné à l'offre ChatGPT Plus. Si OpenAI a annoncé sa volonté de rendre ce nouveau modèle disponible pour tous, le déploiement auprès des utilisateurs gratuits se fera progressivement "dans les prochaines semaines". En attendant donc, il faut être abonné (ou être patient).

La promesse d'une IA toujours plus rapide - à l'image de Claude, son principal rival - mais aussi précise et performante, avec des résultats plus détaillés, justifie-t-elle de passer au premium? La question n'est pas aussi simple et la réponse encore moins, mais on attendra peut-être les annonces de Google en la matière, lors de l'événement Google I/O de ce mardi 14 mai, avant de se faire un premier avis.