Deepfake: comment repérer ces arnaques IA de plus en plus réalistes?

830.000 euros, 25 millions de dollars... Les arnaques au deepfake peuvent rapporter gros à leurs auteurs. Réalisées avec l'intelligence artificielle, ces escroqueries permettent aux cybercriminels de se faire passer pour quelqu'un d'autre, comme une célébrité, une personne de l'entourage de la victime ou un inconnu dans le cadre d'une histoire d'amour.

Derrière ces arnaques, un objectif: soutirer de l'argent à la victime en gagnant sa confiance. Cela, avec une fausse image, vidéo ou voix. En avril 2023, des escrocs ont par exemple tenté de faire croire par téléphone à une mère qu'ils avaient enlevé sa fille, exigeant une rançon d'un million d'euros. Si la police lui a confirmé que sa fille n'avait pas été enlevée, elle a été choquée par la ressemblance de la voix clonée à l'aide de l'IA avec celle de sa fille.

En février 2024, c'est un employé d'une multinationale qui a été piegé par une fausse visioconférence dans laquelle toutes les personnes excepté lui n'étaient pas réelles. Pensant obéir aux ordres de son directeur financier, il a transféré 25 millions de dollars à des escrocs. Plus récemment encore, en janvier, une femme a été escroquée de 830.000 euros par un faux Brad Pitt.

Prêter attention aux détails

S'il est difficile de faire la différence entre un deepfake et une vraie image, vidéo ou voix, cela n'est pas impossible. Des signes peuvent en effet vous mettre la puce à l'oreille.

"Certains deepfakes présentent encore des anomalies visibles: mouvements faciaux incohérents, expressions figées ou transitions étranges, zones floues autour du visage, lèvres mal synchronisées avec l'audio ou manque d'émotions naturelles", souligne Ghislain Mamat, fondateur et PDG de la startup Point Identity, auprès de Tech&Co.

Il faut ainsi prêter attention à ces détails, notamment au niveau du visage de la personne (oreilles...). Ces signes, qui ne sautent pas toujours aux yeux, permettent de détecter un deepfake.

Demander de tourner la tête ou la caméra

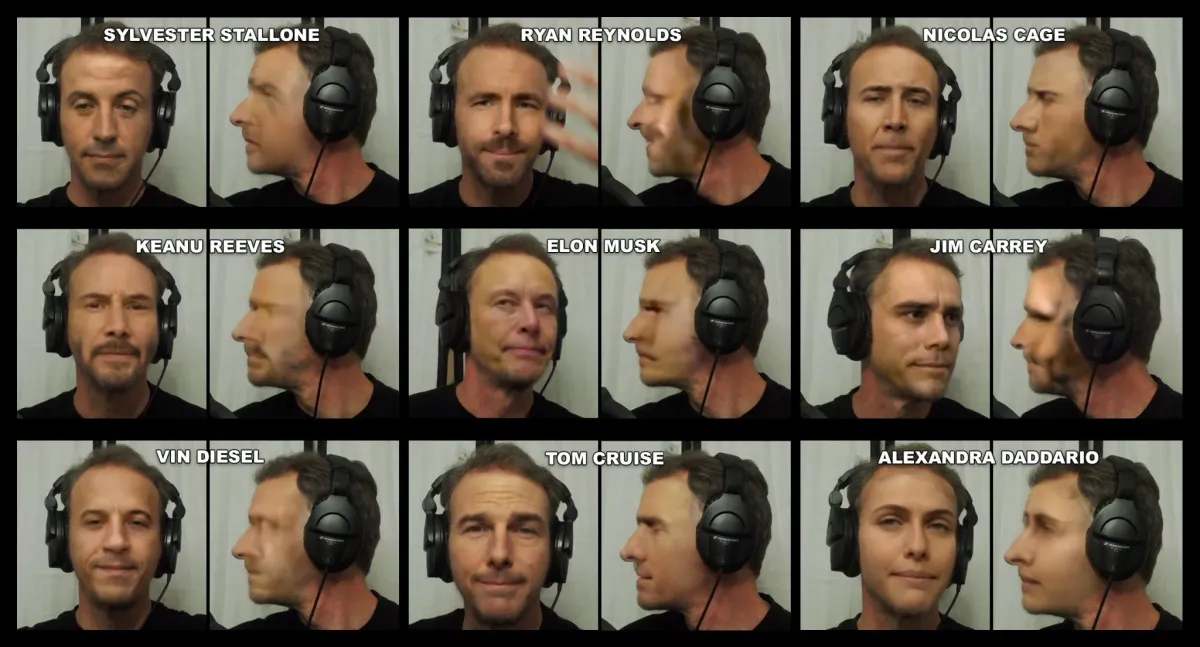

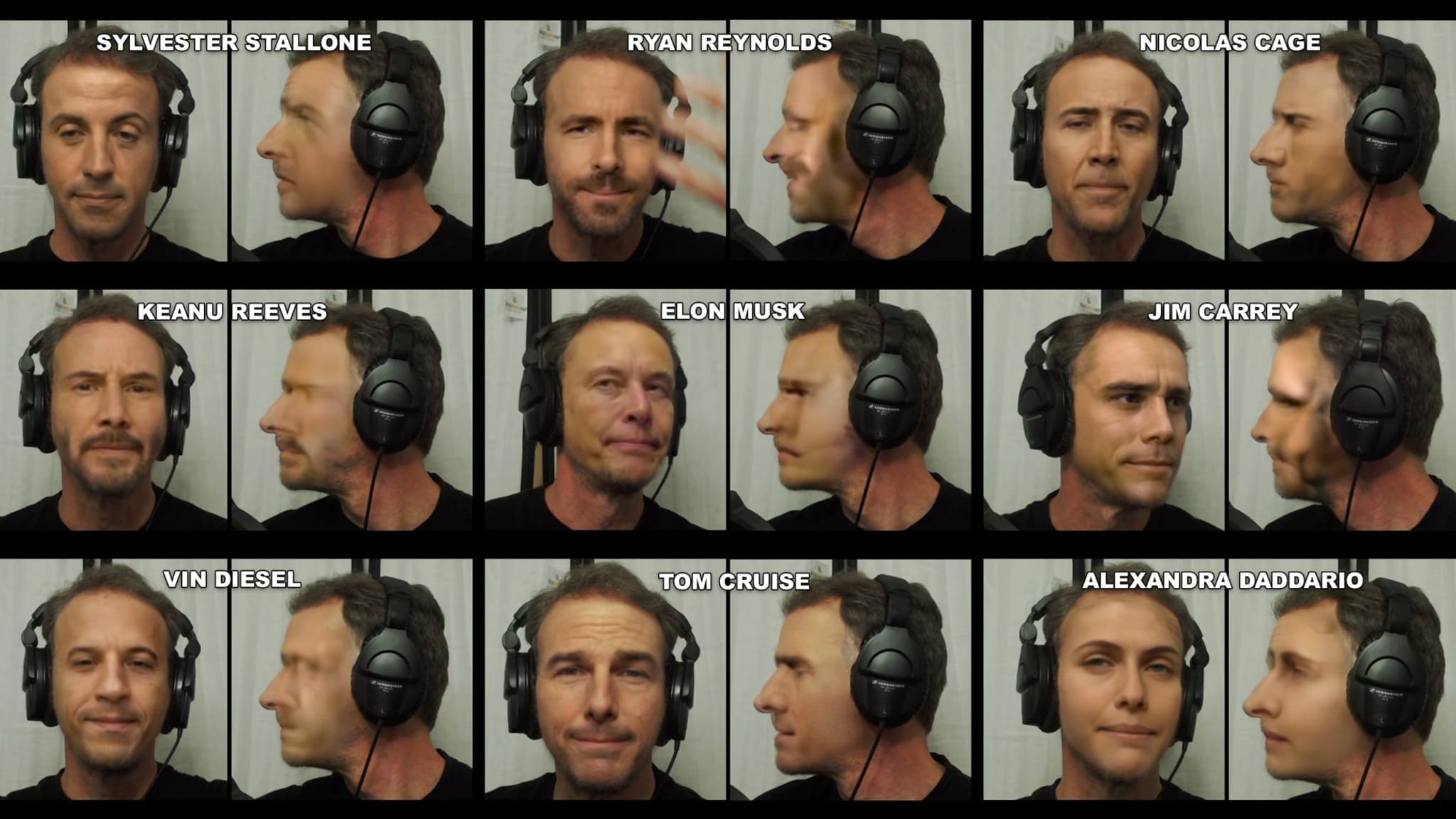

Outre ces détails, il existe d'autres moyens de savoir si un contenu est réel ou non. Demander à son interlocuteur de tourner la tête lors d'une visioconférence est l'un d'entre eux. Comme l'indiquent les chercheurs de Metaphysic, l'entreprise à l'origine des deepfakes de Tom Cruise, les générateurs de ces faux contenus sont incapables de représenter des personnes de profil.

Et, il y a une bonne raison à ça, comme l'expliquent les chercheurs. Que ce soit sur les réseaux sociaux, un album photo ou ailleurs, les personnes n'ont pas ou peu de photos sur lesquelles ils se montrent de profil. Ces données étant rares, les IA n'ont pas une vaste gamme d'images de profil sur lesquelles elles peuvent être entraînées.

On peut aussi demander à son interlocuteur vidéo de faire tourner sa caméra pour montrer son environnement, conseille Arnaud Lemaire, de la société américaine de cybersécurité F5. "Ce que l'IA a, pour l'instant, du mal à recréer", avance-t-il.

Poser une question pour lever le doute

En dehors de ces méthodes, vous pouvez aussi, en cas de doute, poser une question dont seule la personne en face de vous aura la réponse, comme l'a conseillé Gerome Billois, associé en cybersécurité et confiance numérique au sein du cabinet Wavestone, sur France Inter.

Mais, si vous êtes victime d'une arnaque au deepfake, avec un transfert d'argent, il faut prévenir sa banque et porter plainte, souligne Carine Cartaud, directrice fraude et identité chez LexisNexis Risk Solutions, auprès de Tech&Co. Il est d'ailleurs possible de le faire en ligne, avec la plateforme Thesee, qui permet de signaler les escroqueries en ligne.