Comment détecter si un texte a été écrit par ChatGPT?

Des étudiants qui font écrire leur copie par des intelligences artificielles. Des arnaqueurs qui les utilisent pour rédiger des mails de hameçonnage. Après avoir bluffé Internet par sa capacité à rédiger des textes proches d'un humain, l'IA ChatGPT a rapidement été utilisée pour des usages frauduleux ou malveillants.

Les écoles newyorkaises ont même banni l'utilisation de l'IA, créée par la startup californienne OpenAI. Mais comment savoir si un texte a été généré par ChatGPT? Est-ce seulement possible ?

Des indices visibles à la lecture

Même sans logiciel perfectionné, certaines formulations peuvent vous mettre la puce à l’oreille. Par exemple, la présence récurrente de mots génériques et impersonnels plutôt que des mots ou expressions rares. Par exemple, “the” (le), “it” (cela) ou “is” (est) pour les textes en anglais.

La raison? Contrairement aux apparences, ChatGPT n’est pas vraiment un chatbot, mais un algorithme qui calcule la suite la plus probable d’un texte. Si vous lui posez une question, il va donc comprendre que la suite la plus probable est une réponse – mais sa réponse sera constituée des mots qui ont le plus de chances d’apparaître dans sa base de données. Soit des mots passe-partout comme “this” ou “it”, comme l’explique la MIT Technology Review.

Autre indice: comme ChatGPT fonctionne aux probabilités, si plusieurs personnes lui posent exactement la même question, il va leur générer à chacun la même réponse, la plus probable – à quelques détails près. Un bon indice pour les professeurs: s’ils corrigent plusieurs copies qui se ressemblent étrangement, avec les mêmes constructions grammaticales, le même raisonnement, les mêmes exemples… Ils pourraient avoir été générés par un algorithme. C’est ce qui a mis la puce à l’oreille de l’enseignant lyonnais dont la moitié des étudiants de master avaient utilisé ChatGPT pour rédiger leur copie.

Mais à la différence de beaucoup d’humains, ChatGPT ne fait aucune faute de français. Si le texte que vous lisez contient des erreurs d’accord ou de grammaire, il y a donc plus de chances qu’il ait été écrit par un humain.

Des logiciels de détection

Comme pour accompagner l'explosion de ChatGPT, de plus en plus de sites affirment pouvoir détecter l'origine d'un texte avec une précision impressionnante. Mais sans explication sur leur méthode, les promesses sons souvent trop belles pour être vraies.

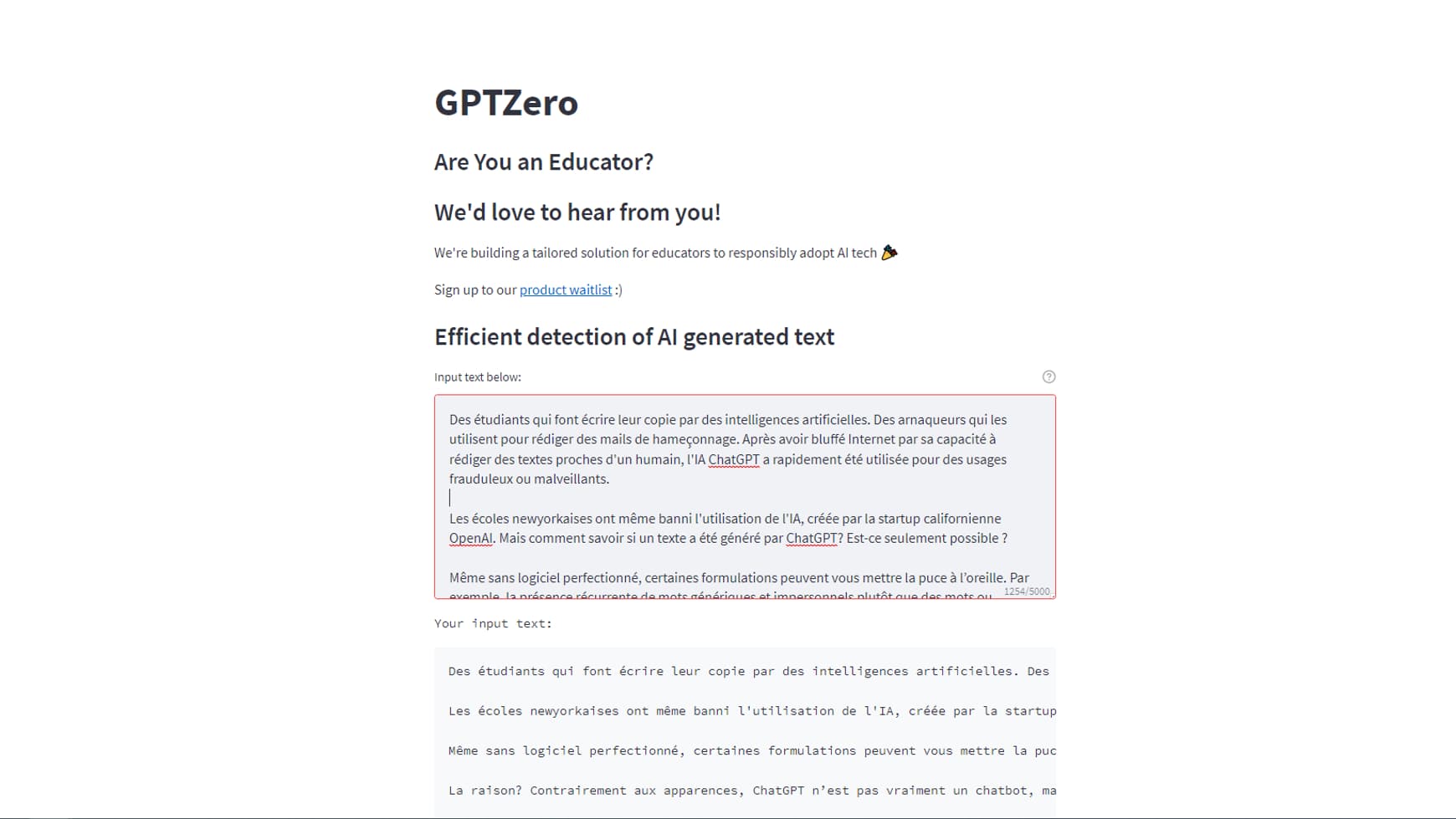

L'un des outils les plus transparents et populaires, c'est GPTZero. Ce site, développé par l'étudiant en informatique Edward Tian pendant ses vacances de Noël, reprend une approche déjà utilisée sur les précédentes IA: si c'est un algorithme qui l'a créé, un algorithme similaire saura le reconnaître

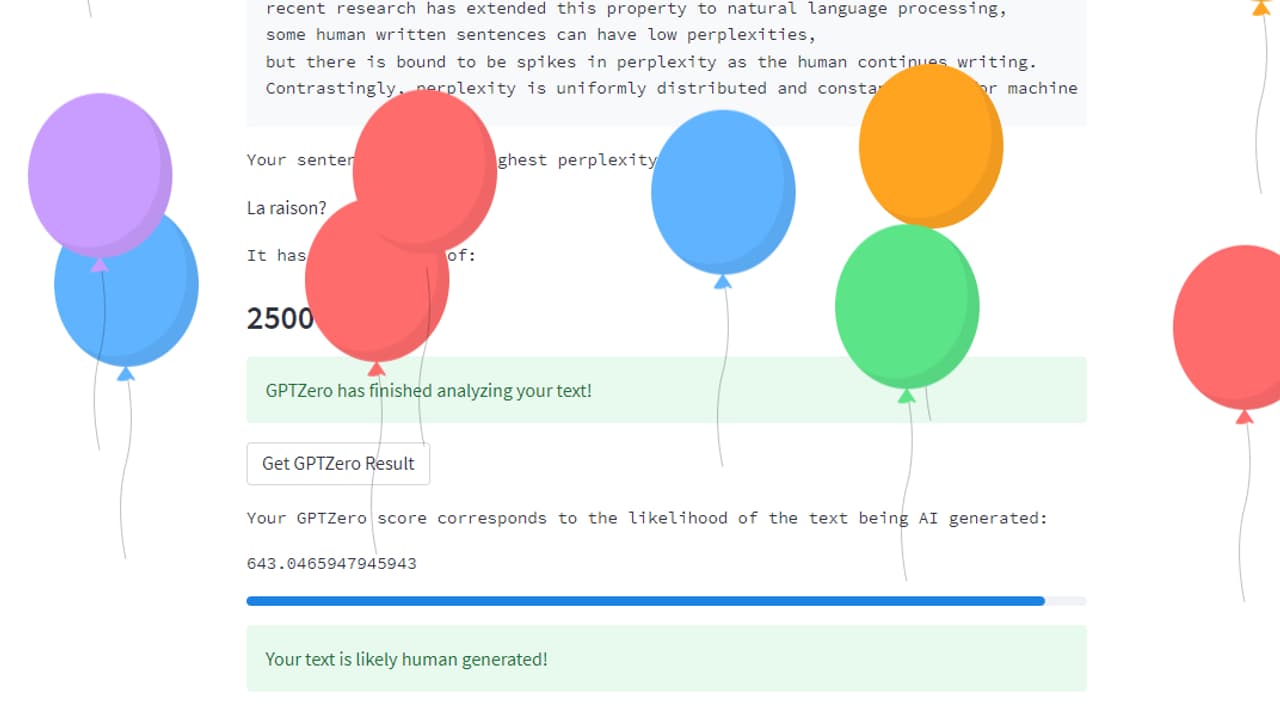

Pour vous dire s'il vient d'une IA ou d'un humain, GPTZero va soumettre votre texte à un modèle antérieur de ChatGPT, appelé GPT-2. "Ça permet de calculer la 'perplexité': est-ce que GPT-2 trouve que le texte lui est familier? Ou est-ce qu'il est surpris par des longueurs de phrases ou des expressions qui ne correspondent pas aux probabilités qu'il a apprises?" explique Edward Tian à Tech&Co.

Il vous suffit donc de rentrer votre texte sur le site, d'appuyer sur Entrée, et si la "perplexité" est élevée, le texte a plus de chances d'avoir été généré par un humain. A cela s'ajoute la "sporadicité" ("burstiness" en anglais), qui évalue à quel point cette perplexité varie au cours du texte: la longueur des phrases générées par IA ne va pas beaucoup varier tout au long du texte, alors que les phrases humaines seront plus aléatoires.

"Je ne suis pas contre l'IA, mais son adoption doit être accompagnée de garde-fous", explique Edward Tian à Tech&Co. "Les gens doivent pouvoir connaître la vérité sur ce qu'ils lisent".

Pas de solution miracle

Mais GPTZero n'est pas capable de vous confirmer à 100% que le texte vient d'un humain ou d'une machine. Pour une raison simple: c'est pour le moment impossible.

Tous les outils de détection actuels sont imparfaits, et se trompent plus ou moins régulièrement. Nous avons par exemple demandé à ChatGPT d'écrire comme un enfant de 4 ans (en anglais): le logiciel a alterné les phrases classiques et des plus courtes, exclamatives. Un texte suffisamment varié pour tromper GPTZero.

Il est aussi facile de rajouter manuellement des fautes à un texte écrit par IA, ou de le reformuler légèrement pour le rendre indétectable. Ce procédé peut même être automatisé: sur Twitter, un informaticien explique avoir créé un programme qui rajoute des espaces invisibles au milieu de certains mots – les transformant ainsi en des mots inconnus par GPTZero, qui est donc "perplexe" et va considérer le texte comme une création humaine.

Enfin, GPTZero est moins efficace sur les langues autres que l'anglais, car GPT-2 a principalement été entraîné sur des textes en anglais.

Edward Tian a conscience de ces failles. Il rappelle que son modèle est pour le moment pensé pour détecter la triche académique. Peu importe qu'il laisse passer les textes écrits comme un enfant de 4 ans.

"J'espère pouvoir me lancer prochainement à temps plein dans l'amélioration du logiciel, pour ajouter de nouveaux critères de sélection et pour qu'il puisse servir à tout le monde", explique l'étudiant à Tech&Co.

"Marquer" les textes générés par IA en amont

Ces méthodes de détection ont une autre faille: "Pour calculer la 'perplexité' d'un algorithme devant un texte, il faut avoir beaucoup d'informations sur l'algorithme en question", note Edward Tian pour Tech&Co. "Le modèle lui-même, les paramètres, les poids..."

GPTZero fonctionne grâce à GPT-2, un modèle publié par OpenAI en 2019, mais qui est déjà largement dépassé par ChatGPT. "Si d'autres entreprises créent des IA encore plus perfectionnés mais ne sont pas transparentes, la détection pourrait devenir beaucoup plus compliquée", admet Edward Tian auprès de Tech&Co.

C'est pourquoi l'une des stratégies serait de rendre ces textes générés par IA clairement identifiables dès leur création, en leur ajoutant un signe distinctif qui ne laisserait aucune place au doute.

C'est la stratégie suivie par OpenAI: l'entreprise compte modifier ses prochains algorithmes pour faire en sorte que "chaque fois que GPT génère un texte long, il y ait un signal secret imperceptible dans ses choix de mots, que vous pouvez utiliser pour prouver plus tard que, oui, cela vient de GPT", selon le chercheur Scott Aaronson qui a récemment rejoint la startup. À l'université comme sur internet, la course-poursuite ne fait donc que commencer.