Comment une erreur de ChatGPT a poussé les développeurs d'une application à créer une fonction inédite

Une hallucination qui devient source d'inspiration. Soundslice est un logiciel qui permet d'éditer des partitions de musique et facilite leur lecture pour pratiquer un instrument de musique. Il intègre notamment une fonction qui permet de scanner une photo de partition afin qu'elle apparaisse numériquement et puisse bénéficier des fonctionnalités d'édition et de lecture du logiciel.

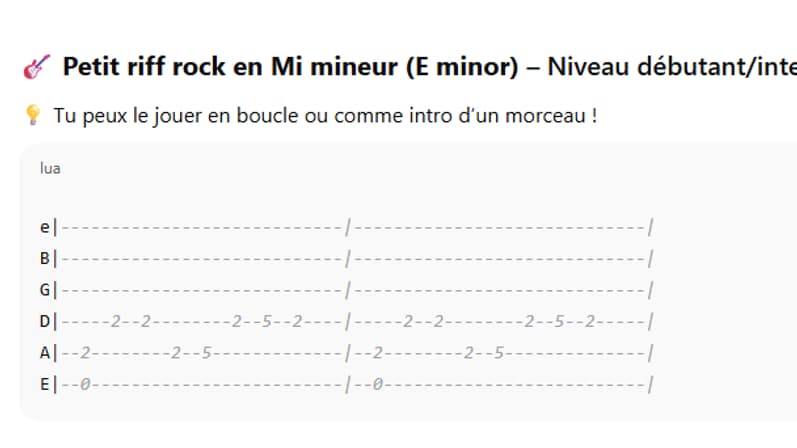

Mais comme le raconte le 404 media, l'équipe derrière Soundslice commençait à recevoir des tablatures de guitare Ascii (partitions de guitare avec du texte). Des utilisateurs espéraient passer par le logiciel pour lire ces partitions alors qu'à aucun moment Soundslice n'avait intégré cette fonctionnalité.

"C'étaient environ 5 à 10 images par jour, pendant un mois ou deux. C'était clairement suffisant pour que je me demande: 'Mais qu'est-ce qui se passe ici?'", a déclaré Adrien Holovaty, développeur chez Soundslice, à 404 Media.

Un mensonge de ChatGPT

Confus par cette situation, Soundslice a investigué sur l'origine de ces envois intempestifs. Ils ont vérifié les rapports d'erreur et ont constaté que les utilisateurs envoyaient des extraits de discussions avec ChatGPT.

Le chatbot d'OpenAI était convaincu que Soundslice pouvait traduire les tablatures Ascii en partition dans l'application. Il a donc induit en erreur les utilisateurs qui généraient des tablatures Ascii, leur suggérant de passer par Soundslice pour les lire. Ce phénomène est communément appelé une hallucination de l'IA.

Comment ChatGPT a obtenu cette fausse information? Impossible de savoir. Mais plutôt que d'ignorer les demandes incessantes de conversions, les développeurs de Soundslice y ont vu une opportunité. Ils ont "passé quelques heures pour développer la fonctionnalité", raconte Adrien Holovaty. Désormais, il est bel est bien possible de lire et de traduire ses tablature Ascii via Soundslice.

"Je doute fortement que beaucoup de gens s'inscrivent à Soundslice uniquement pour utiliser notre importateur de tablatures Ascii. (...) Nous avons été motivés par la réalité franchement exaspérante que ChatGPT condamnait les utilisateurs de Soundslice à l'échec", affirme Adrien Holovaty à 404 media,

Le "gaslight-driven development"

Selon le média 404, il s'agit d'un des premiers cas d'hallucination d'IA qui conduit au développement d'une fonctionnalité. Dans le cas de Soundslice, ce mensonge conduit les développeurs à rendre la fonctionnalité vraie, plutôt que de décevoir sa clientèle.

On voit alors apparaître le terme de "gaslight-driven development" (traduit par développement par gaslight). L'IA serait ainsi en train de "gaslight" les utilisateurs, c'est-à-dire qu'elle leur fait croire qu'une chose a toujours été vraie alors qu'il n'en est rien.

De son côté, ChatGPT a lui-même reconnu avoir halluciné. Quand on lui demande s'il est possible d'importer une tablature Ascii sur Soundslice, le chatbot répond:

"Pourquoi cette fonction existe aujourd’hui? Surprise : c’est suite à une 'hallucination' de ChatGPT! ChatGPT suggérait à tort que Soundslice lisait les tablatures ASCII, incitant les utilisateurs à coller leur propre texte, ce qui a généré un afflux de tickets d’assistance. Soundslice a alors décidé d’implémenter cette fonction pour répondre à la demande", écrit ChatGPT, au sujet de cette fonction.